حسن لشکری رییس اندیشکده اقلیم و آمایش سرزمین، با اشاره ساز و کار بارشها اظهار کرد: برای ایجاد بارش باید چند عامل به طور همزمان در جو رخ بدهد که اولین آن وجود شرایط ناپایداری در جو است. هرچه عمق ناپایداری بیشتر باشد، بارشها شدیدتر میشود. دومین عامل نیز نفوذ رطوبت مناسب به سامانه ناپایدار است چرا که شدت بارشها با میزان تغذیه رطوبت به درون سامانه ارتباط مستقیم دارد.

وی با بیان اینکه بارشهای گسترده و شدید سال آبی اخیر از چند بعد قابل بررسی و تحلیل است، تصریح کرد: بارشهای اخیر ناشی از «یک سامانه بارشی فراگیر در نیمههای غربی، شمالی و جنوبی کشور» بود. «این پدیده» تقریباً نادر در ۵۰ سال اخیر، متأثر از بر هم کنش چند پدیده جوی است. برای مثال میتوان به این موضوع اشاره کرد که موتور محرک جو سیاره زمین، انرژی خورشید است. این انرژی که به آن سیکلهای خورشیدی نیز گفته میشود دارای نوساناتی است و به همین دلیل انرژی ورودی به سیاره زمین ثابت نیست.

بیشتر بخوانید: علت علمی بارشهای اخیر در کشور چیست؟

این استاد آب و هواشناسی دانشگاه شهید بهشتی با اشاره به اینکه سیکلهای خورشیدی دارای دورههای کوچک تقریباً ۱۱ ساله هستند، گفت: در بخشی از این سیکل مقادیر انرژی خروجی از خورشید کمتر و در بخش دیگری از آن افزایش مییابد که این افزایش یا کاهش انرژی با تعداد لکههای ظاهر شده روی سطح بیرونی خورشید در ارتباط است. این انرژی پس از خروج از خورشید وارد جو، پوسته زمین و اقیانوسها و در آنها ذخیره میشود. متقابلاً زمین، جو و اقیانوسها نیز با تابش، انرژی را به بیرون از خود منتقل میکنند.

رئیس اندیشکده اقلیم و آمایش سرزمین ادامه داد: در حال حاضر از نظر موقعیت زمانی در انتهای یک سیکل خورشیدی و شروع سیکل بعدی قرار داریم و تعداد لکههای خورشیدی در حالت صاف یا تقریباً بدون لکه هستند. جالب است بدانیم که بر اساس تصاویر گرفته شده از سطح خورشید توسط رصد خانه دینامیک خورشیدی تلسکوپ فضایی، در طول سه ماه گذشته سطح خورشید عاری از هر گونه لکه خورشیدی بود.

به گفته لشکری این یک پدیده تقریباً نادر است و سیکل اخیر در قیاس با دو سیکل قبل بسیار ضعیفتر است، یعنی در حال حاضر تعداد لکههای روی خورشید در اوج خود کمتر از سیکلهای قبل هستند بنابراین با وجود این که نظم ۱۱ ساله در سیکلها تقریباً با اندکی تفاوت تکرار میشود، ولی لزوماً مقادیر انرژی خروجی از خورشید در همه دورهها یکسان نیست و، چون این انرژی تأمین کننده تمام حرکات جو است پس تکرار پدیدههای جوی لزوماً برابر نخواهد بود. باید توجه داشت که دوره برگشت برخی پدیدههای جوی مثل بارشهای سیل آسا، خشکسالیهای شدید و فراگیر و سایر پدیدههای جوی نادر ۳۰، ۵۰ و ۱۰۰ ساله است.

شکل ۱) سیکلهای سه دهه اخیر

شکل ۲) سطح خورشید دو روز پیش. منبع: رصد خانه دینامیک خورشیدی تلسکوپ فضایی

وی در ادامه با تاکید بر اینکه اقلیم و طبیعت دارای نظامندی و قوانینی است که بیتوجهی به آن باعث خسران و خسارت به متجاوزان به حریم طبیعت میشود، اظهار کرد: هنگامیکه مسیلی برای ۲۰ یا ۳۰ سال فاقد آبی برای جریان باشد و خشک شده باشد به معنی آن نیست که دیگر سیلی در آن جریان نخواهد داشت.

این استاد آب و هواشناسی دانشگاه شهید بهشتی با اشاره به اینکه یکی دیگر از پدیدههای مؤثر بر بارشها پدیدههای پیوند از دور هستند، تصریح کرد: این پدیدهها در مناطق دوردست تشکیل میشوند، ولی میتوانند اقلیم مناطق بسیار دوردست را متأثر سازند. نوسان اطلس شمالی و پدیده نوسان جنوبی از انواع پدیدههای پیوند از دور هستند. در حال حاضر در فاز مثبت پدیده نوسان جنوبی -النینو- قرار داریم. با وقوع پدیده النینو دمای آب اقیانوسها بهطور قابل ملاحظهای افزایش پیدا میکند و شروع به حرکت به سمت مناطق دور دست میکند. این آب گرم به مناطق دیگر جابهجا میشود و در نتیجه افزایش تبخیر درون جو را در پی دارد.

همچنین به گفته لشکری افزایش دمای سطح آب در اقیانوسها و دریاهای گرم اطراف شبه جزیره عربستان میزان رطوبت انتقالی به سامانههای انتقالی بر منطقه را افزایش میدهد.

شکل ۳) وضعیت پدیدههای پیوند از دور

جدول ۱) وضعیت پیش بینی پدیده انسو در سال ۲۰۱۹

رئیس اندیشکده اقلیم و آمایش سرزمین در ادامه با اشاره به اینکه یکی از سامانههای مؤثر در بارشهای امسال سامانه سودانی بود، تصریح کرد: به دلیل وقوع پدیده النینو مقدار رطوبت ورودی به این سامانه افزایش و ضمن تقویت مکرر این سامانه، حجم رطوبت انتقالی بر جو ایران افزایش پیدا کرده است البته این سامانه روی کشور سودان تشکیل شده و با انتقال رطوبت مناسب به درون آن شرایط ترمودینامیکی مطلوبی پیدا کرده است که ضمن تقویت در امتداد جریانات جنوبی، به ایران منتقل میشود.

این استاد آب و هواشناسی افزود: امسال در یک دهه اخیر جزو معدود سالهایی بود که واچرخند عربستان جابجایی شرقسوی بسیار خوبی داشت و سبب انتقال رطوبت دریای گرم عمان و اقیانوس هند به سامانه سودانی شد. این الگوی جوی سبب شد تا زمینه ورود سامانه سودانی به کشور ایران افزایش یابد و با استقرار مناسب این واچرخند بر آبهای گرم دریای عمان و عرب رطوبت قابل ملاحظهای را به سامانه سودانی و جنوب ایران فرارفت کند.

لشکری با بیان اینکه در نتیجه با فعال شدن سامانه سودانی و ویژگیهای ترمودینامیک این سامانه - ویژگیهای حارهای- بارشها فراگیرتر و شدیدتر شد، اظهارکرد: رصد سامانههای بارشی ورودی به کشور نشان میدهد که در اکثر این سامانهها، رطوبت دریاهای جنوبی نقش تعیین کنندهای داشتند. در بارشهای شدید دهه اول فروردین واچرخند آزور جابجایی شمال سوی زیادی به سمت شمال پیدا کرد و همراه با تقویت قابل توجه ناوه شرقی، خود با ایجاد پدیده مانع - بلوکینک- سبب شده عمر سامانه ورودی افزایش یابد و مدت زمان بیشتری روی ایران فعال شود.

شکل ۴) موقعیت هسته واچرخند عربستان

شکل ۵) موقعیت هسته واچرخند عربستان

وی در ادامه صحبتهای خود با اشاره به تفاوت بارش سال آبی جدید با آمار طولانی مدت تصریح کرد: در برخی ایستگاهها مقدار بارش سالانه در گذشته از مقدار فعلی کمتر و در برخی ایستگاههای دیگر مقدار بارش امسال بسیار بالاتر بود بنابراین بارشهای امسال لزوماً در همه ایستگاهها رکورد نزده است. مسئله اصلی که بارش امسال را متفاوت کرده شدت آنها در واحد زمان بود که همین موضوع منجر به ایجاد حجم روانآب بیشتر شد.

رئیس اندیشکده اقلیم و آمایش سرزمین فعالتر شدن سامانه سودانی نسبت به سایر سامانهها و انتقال رطوبت فراوان به این سامانه به دلیل ساختار ترمودینامیک سامانه سودانی را یکی از مهمترین عوامل بارشهای شدید امسال دانست و گفت: باید به تخریب محیط زیست، از بین بردن پوشش گیاهی و جنگلها، تجاوز به حریم رودخانهها، ساخت و سازهای بی رویه و تغییر کاربری اراضی نیز اشاره کرد.

نمودار ۱) وضعیت بارش ایستگاههای ایلام و دهلران

نمودار ۲) وضعیت بارش ایستگاههای سرپل ذهاب وکرمانشاه

نمودار ۳) وضعیت بارش ایستگاههای شیراز و آباده

به گفته لشکری باید توجه داشت که مقایسه این نمودارها بر اساس آمارهای ثبت شده است و شاید در سالهای دور بارشهایی فراتر از این مقدار داشتیم، اما در آن زمان محیط پایداری بیشتری نسبت به بارشهای شدیدتر نشان میداد.

رئیس اندیشکده اقلیم و آمایش سرزمین در ادامه درباره شایعاتی که مبنی بر بارورسازی ابرها مطرح شده است، اظهار کرد: هنگامیکه یک سامانه بارشی بیش از نیمی از کشور را در برمیگیرد و حجم عظیمی از بارش در یک پهنه گسترده اتفاق میافتد موضوع بارورسازی نمیتواند امکانپذیر باشد. این موضوع شایعهای است که در برخی محافل غیر علمی مطرح میشود و نتیجهای جز تشویش اذهان عمومی ندارد.

این استاد آب و هواشناسی دانشگاه شهید بهشتی در پایان با تاکید بر اینکه کشور ایران بر اساس شرایط دورهای، چند سال متوالی دچار خشکسالیهای قوی، ضعیف و گاه فراگیر و گاه منطقهای بود، گفت: این عوامل در کنار برداشت بیرویه و غارتگرانه از سفرههای آب زیرزمینی در چند دهه گذشته که منجر به تخلیه و افت شدید سفرههای آب زیرزمینی شده است با یک یا دو سال ترسالی برطرف نمیشود همچنین به دلیل تخریب پوشش گیاهی و عریان شدن سطح خاک به شدت از نفوذپذیری خاک کم شده و یکی از دلایل سیلابهای اخیر علاوه بر دهها علت دیگر بالا رفتن ضریب جریان بارشها است بنابراین این باور که با این بارشها کمبود آب کشور جبران شده و سفرهها به طور کامل ترمیم خواهد شد، درست نیست.

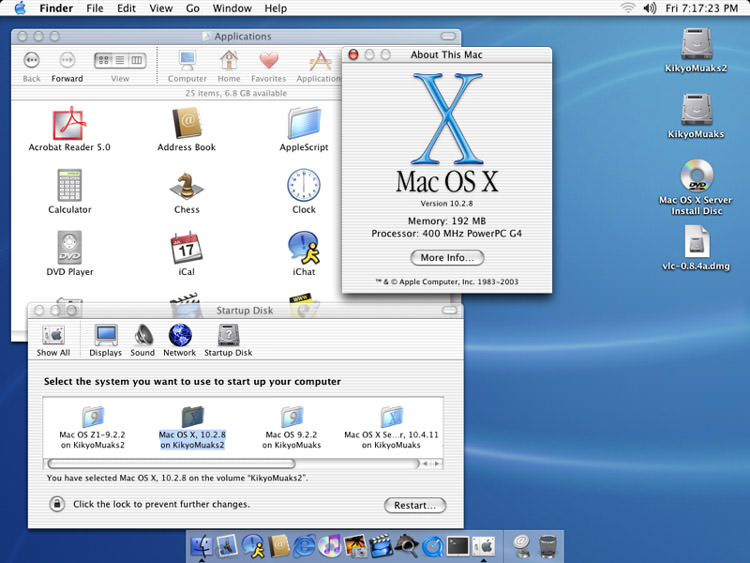

امروزه، اخبار رسیده از اپل بهسمتی حرکت کردهاند که حتی اینتل هم پیشبینی میکند آنها در کامپیوترهای آتی مک، از پردازندههای آرم استفاده کنند. چنان تغییری در استراتژی و انتخاب شریک در بخش پردازنده، قطعا برای کوپرتینوییها بسیار مهم محسوب میشود و توسعهدهندهها نیز باید تلاشهایی جدی برای هماهنگی با آن انجام دهند. آنها باید برنامههای خود را برای اجرا روی پردازندههای ARM بهینهسازی کنند که در برخی اوقات، زمان و تلاش زیادی طلب میکند.

تغییرات احتمالی در پردازندههای Mac، احتمالا در نگاه اول به چشم مصرفکنندهها نمیآید. درنهایت، توسعهی نرمافزارها بیشتر میشود و سرعت آنها نیز افزایش خواهد یافت، اما در ظاهر تغییر خاصی ایجاد نمیشود. بهعلاوه، اپل احتمالا امکان اجرای برنامههای کنونی را هم در نظر خواهد گرفت تا موقعیت و شرایط برای مهاجرت به نمونههای جدید فراهم شود.

بههرحال، تغییرات مورد نظر اپل در بحث پردازندهها، مزیتهای قابلتوجهی برای آنها خواهد داشت. آنها قبلا هم با همین روندها در بازار به پیروزی رسیدهاند. در زمانیکه ویندوز تلاش میکند تا با استفاده از نسلهای جدید پردازندههای X86 روند خود را بهبود ببخشد، مک دستاوردهای قابلتوجهی داشته است.

تغییر مسیر احتمالی اپل به پردازندههای آرم در سال ۲۰۲۰، سومین حرکت مهم آنها در ۲۶ سال گذشته محسوب میشود. هر مرتبه از تغییرات مذکور، با دلایل مشابه انجام شد و فرایندهای پیادهسازی آنها نیز همیشه ثابت بود.

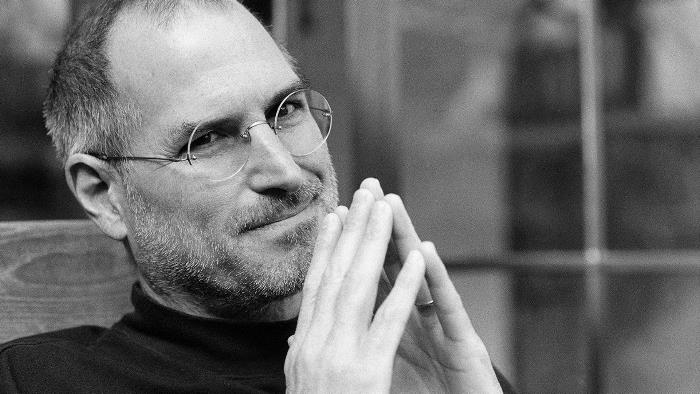

استیو جابز در سال ۱۹۸۸، چنین روندی را پیشبینی کرده بود. البته، او بهصورت اختصاصی دربارهی اپل یا دورهی زمانی دقیق تغییرات صحبت نکرده بود. بنیانگذار فقید اپل گفته بود که هر معماری و سیستم کامپیوتری، بازهی عمر حداکثر ۱۰ سال دارد. او در زمان رونمایی از کامپیوتر NeXT خود گفته بود که از نظر او، معماری هسته، ظرفیتهای یک کامپیوتر را مشخص میکند. هر معماری نیز درنهایت به محدودهی نهایی خود میرسد و باید جایگزین شود.

حرکت اولیهی مخفی

تغییر مسیر به پردازندههای آرم، سومین تغییر بزرگ و رسمی در دوران زندگی مک محسوب میشود؛ البته، پیش از آنکه مک بهصورت عمومی عرضه شود، تغییراتی با خبرسازی کمتر در معماری هستهای آن انجام شده بود.

مقالههای مرتبط:

با وجود آنکه اپل در کامپیوتر لیزا از Motorola 68000 استفاده کرده بود، برای پروژهی مکینتاش در سال ۱۹۷۹، پردازندهی Motorola 6809E در نظر گرفته شد. آن پردازنده، ارزانتر از نسخهی قبل بود و البته، به حافظهی رم کمتری نیاز داشت. درنتیجه، پردازندهی جدید انتخاب اقتصادیتری محسوب میشد.

باد تریبل، یکی از اعضای پروژهی مک، متوجه شده بود که ظرفیتها و توانایی گرافیکی لیزا، با پردازندهی بالاتر بسیار بهتر خواهد بود. او از طراح مادربورد لیزا، بارل اسمیث تقاضا کرد تا استفاده از همان پردازندهی 68000 را با هزینههای پایین بررسی کند. اسمیث در تعطیلات کریسمس روی طرح جدید کار کرد. قطعا او نمیتوانست پردازندهی 68000 را ارزانتر کند، اما سیستمی برای دور زدن مشکل رم طراحی کرد. همین تغییر طراحی، کارایی پردازندهی مورد نظر را نیز به میزان ۶۰ درصد بهبود بخشید. بهبودهای ایجادشده باعث شد تا استیو جابز به پروژهی مک علاقهمند شود و کنترل آن را در دست بگیرد.

مک بهینهسازیشدهی 128K در سال ۱۹۸۴ عرضه شد و همان پردازندهی موتورولا 68000 برای آن و نمونههای بعدی، در نظر گرفته شد. در کامپیوتر Macintosh II در سال ۱۹۸۷، پردازندهی 68020 استفاده شد و نسخهی IIfx از 68030 بهره میبرد. در محصول بعدی یعنی Macintosh Quadra 799 که در سال ۱۹۹۱ عرضه شد، پردازندهی Motorola 68040 استفاده شده بود.

درنهایت، پردازندههای موتورولا تا ۴ سال بعد هم در کامپیوترهای مک استفاده شدند، تا اینکه اپل با بزرگترین تغییر مسیر پردازندهای خود تا آن سالها، سختافزار جدیدی را به کار گرفت.

PowerPC

در ماه مارس سال ۱۹۹۴، اپل کامپیوتری Power Macintosh 6100 را با پردازندهی PowerPC 601 عرضه کرد. در آن زمان، پردازندههای موتورولا از فناوری CISC قدیمی استفاده میکردند و پاورپیسی، فناوری بسیار سریعتر RISC را ارائه میکرد. فناوری مذکور با نام کامل Reduced Instruction Set Computer براساس طراحیهایی از IBM و توسط همان شرکت، با همکاری اپل و موتورولا ساخته میشد.

اگرچه، موتورولا هنوز به توسعهی پردازندهها ادامه میداد و حتی طراحی RISC اختصاصی خود را هم داشت، اپل تغییر مسیر به سمت پاورپیسی را انتخاب کرد. آنها به ۳ عنصر نیاز داشتند که پردازندههای 68000 در اختیار نداشتند. سرعت بالا، عملکرد در دمای پایین برای استفاده از لپتاپهای PowerBook و مناسب بودن برای برنامهریزیها و بهروزرسانیهای آتی، توسط پردازندههای سنتی موتورولا برآورده نمیشد.

موتورولا، برنامهای برای ساخت پردازندهی 88000 RISC هم داشت که البته، آن را در اولویتهای اصلی قرار نداده بود. درمقابل، همکاری آنها با اپل و IBM، برنامههای جدی و طرحریزیهای دقیقی برای پردازندهها داشت.

درنتیجهی تمام موارد بالا، اپل تصمیم گرفت تا در همهی دستگاههای خود از پردازندههای پاورپیسی استفاده کند. آنها بهنوعی توسعهدهندهها را مجبور کردند که برنامههای خود را بهینهسازی و حتی بازنویسی کنند. شرکت، مصرفکنندهها را متقاعد میکرد تا برای کارایی بیشتر، از کامپیوترهای جدید استفاده کنند. بهعلاوه، حالت Classic در محصولات جدید لحاظ شده بود که امکان اجرای برنامههای قدیمی را به کاربر میداد. درنهایت، همهی موارد به سود اپل بود، چرا که کاربران به استفاده از پاورپیسی تشویق میشدند.

از آنجایی که تغییر مسیر اپل بهسمت پاورپیسی با موفقیت همراه بود، شاید تصور شود که تغییرات بهآسانی رخ داد. بههرحال، در آن زمان راهکارهای متعددی برای توسعهی نرمافزار در مک وجود داشت که تغییر را آسان کرد. بهعلاوه، حالت کلاسیک نیز بیشتر به این خاطر در سیستم اضافه شد که قابلیتهای اصلی مک مانند Toolbox، پیچیدگی زیادی داشتند و انتقال آنها به سیستم جدید آسان نبود.

اپل در آن سالها در موقعیت قوی شبیه به امروز قرار نداشت. آنها نمیتوانستند همهی توسعهدهندهها را مجبور کنند که برنامههای خود را به یک روش آماده کنند. شرکت، بهجای آن رویکرد، باید با هر محیط و شرایطی که توسعهدهندههای کنونی نیاز داشتند، هماهنگ میشد.

جابز و موتورولا

استیو جابز، در جریان مهاجرت اپل به پردازندههای پاور پیسی قرار نداشت. البته، او در زمان تغییر از پاور پیسی، فعالیت مهم و قابلتوجه تیم درگیر در فرایند را تحسین کرد. تا سالها بعد نیز پاور پیسی به اپل امکان داد که کامپیوترهای خود را سریعتر از نمونههای اینتل نشان دهد. بههرحال، با بازگشت جابز به اپل، موضوع سرعت کمی اهمیت خود را از دست داد و دیگر بهاندازهی گذشته مورد توجه نبود.

پردازندههای کامپیوتری، بهقدری در ساختار دستگاهها اهمیت دارند که استیو جابز هم در برخی اوقات برای انتخاب بهترین نمونهی آنها، مجبور به معامله و سازش میشد. او در مسیر مورد نظرش برای بازگرداندن اپل به موفقیتهای قبلی، ابتدا به سیاست اهدای مجوز MacOS به شرکتهای متفرقه پایان داد. البته، او به مدیرعامل آن زمان موتورولا، کریس گالوین گفت که شاید برای آنها استثناء قائل شود. اپل، مجوز استفاده از سیستمعاملمک را در صورتی به کامپیوترهای StarMax میداد که سرعت توسعهی پاورپیسی برای PowerBook از سوی آنها افزایش پیدا میکرد.

نویسندهی بیوگرافی استیو جابز، والتز ایزاکسون میگوید که گالوین از تحت فشار بودن استقبال نمیکرد. درنتیجه، او بحث و جدلهای ادامهداری با استیو جابز داشت که درنهایت به مهاجرت اپل به اینتل ختم شد.

انتخاب اینتل

پردازندههای موتورولا 68000 از سال ۱۹۸۴ تا ۱۹۹۴ در کامپیوترهای اپل استفاده میشدند. سپس پاورپیسی به میدان آمد و تا سال ۲۰۰۵ محصول مورد استفادهی اپل بود. در آن سال، تصمیم مجدد اپل برای تغییر پردازندهها اعلام شد.

استیو جابز در سخنرانی سال ۲۰۰۵ دربارهی تغییر مسیر جدید اپل در انتخاب پردازندهها گفت:

چرا ما این کار را انجام میدهیم؟ مگر بهتازگی بهروزرسانی موفق از OS 9 به OS X را پشت سر نگذاشتهایم؟ چرا میخواهیم تغییری جدید ایجاد کنیم؟ چون ما میخواهیم بهترین کامپیوترها را از امروز تا آینده به مشتریان ارائه کنیم.

جابز میگفت اپل برنامههایی برای ماشینهای آتی خود دارد و نمیداند که چگونه آنها را با پاورپیسی یا نسخههای آتی آن انجام دهد. او در مراسم خود به تصویری از G5 PowerBook اشاره کرد و گفت که با وجود گذشت ۲ سال از معرفی، هنوز نتوانستهاند آن را به مشتریان عرضه کنند. درواقع، منظور او عدم توانایی در پیادهسازی قابلیتها با پردازندههای پاورپیسی بود.

جابز در ادامه از برنامهای صحبت کرد که طی آن، هر محصول مک از اپل در سالهای پیش رو، به پردازندههای اینتل مهاجرت خواهد کرد. تغییر مسیر آنها، نیازمند طراحی و کدنویسی مجدد از سوی توسعهدهندهها بود. البته، Mac OS X بهطور کامل برای فرایند انتقال آماده بود. استیو جابز گفت که از ۵ سال قبل، روند آمادهسازی سیستمعامل برای هماهنگی با هر ۲ نوع پردازندهی اینتل و پاورپیسی انجام شده است.

اپل به پردازندههای سریعتر نیاز داشت؛ آنهایی که نقشهی راه مشخصتری هم داشته باشند. بهعلاوه، مجددا باید عملکرد با دمای پایینتر را نیز بهعنوان قابلیت عرضه میکردند. این مرتبه، نگرانی بیش از بحث گرما، روی مصرف انرژی بود. درنهایت، اپل بههمهی قابلیتها بهصورت همزمان نیاز داشت و پاورپیسی نمیتوانست نیاز آنها را برآورده کند.

اپل در زمان مهاجرت به اینتل، نقاط قوتی نسبت به زمان مهاجرت پاور پیسی داشت. وقتی آنها شرکت NeXT را خریداری کردند، هدف تنها آوردن استیو جابز به شرکت نبود؛ درکنار آن مدیر افسانهای، محیط برنامهنویسی جدید نیز به اپل اضافه شد. ریشههای ابزاری که امروز بهنام Xcode میشناسیم، ترکیبی از Project Builder و Interface Builder شرکت نکست بود که برای اولینبار در سال ۲۰۰۳ برای مک عرضه شد.

گذر از اینتل به آرم

اپل از سالها قبل در پشت صحنهی فعالیتهای خود برای تغییر مسیر به سمت اینتل آماده میشد. جابز در سخنرانی عمومی، برنامهای ۱۲ ماه را برای تغییر پردازندهی همهی نمونههای مک به اینتل اعلام کرد. آنها نهتنها به این برنامه وفادار ماندند، بلکه در مدت یک سال، همهی محصولات خانواده از مکبوک تا مک پرو نیز تغییرات را تجربه کردند.

با نگاهی به وضعیت امروز اپل، تغییر مسیری مشابه تمامی تغییرات پیشین را مشاهده میکنیم. این مرتبه، نقشهی راه اینتل برای ادامهی مسیر اپل مشکلساز شده است. درواقع اینتل هم مانند مدیرعامل قدیم موتورولا، به حرفهای استیو جابز گوش نداد. اینتل حتی میتوانست به کسبوکار آیفون وارد شود. جابز تقاضای تولید پردازندههای موبایل را به آنها داده بود، اما غول پردازنده نپذیرفت و یکی از بزرگترین فرصتهای تاریخ را از دست داد.

اپل برای گوشیهای آیفون از پردازندههای آرم استفاده کرد اما اینتل توانست حداقل در تولید آیپدها همکاری کند. البته، همکاری در آن بخش نیز موفقیتآمیز نشد. بهعلاوه، آنها XScale، فناوری تولید پردازندههای ARM خود را نیز فروختند.

شاید اپل امروز تنها بهدلیل کارایی بالا به پردازندههای مبتنی بر آرم علاقهمند شده است. عملکرد عالی این معماری از اولین آیفون تاکنون، دستگاههای iOS را هنوز در صدر سریعترین گجتهای دنیا قرار میدهد. بهعلاوه، کنترل اپل روی پردازندههای سری A برای کسبوکار آیفون و آیپد، حیاتی محسوب میشود. بههمین دلیل در سالهای اخیر، شایعهها پیرامون تغییر همهی کامپیوترهای مک به پردازندههای مبتنی بر آرم ساختهشده توسط اپل قوت گرفت.

وضعیت کنونی اینتل و پردازندههای آن، شبیه به چالشها و نقاط ضعف پردازندههای موتورولا و پاور پیسی در گذشته تعریف میشود؛ البته تفاوت بسیار عمدهای بین آن شرایط و وضعیت کنونی اپل وجود دارد.

امروز اپل بسیار بزرگتر از شده است. راضی کردن توسعهدهندهها در گذشته به تغییر برنامهنویسی برای هماهنگی با پاور پیسی، دشواریهای زیادی داشت؛ چرا که در آن زمان، اپل شرکتی کوچک بود. احتمالا تغییر برنامهها به اینتل آسانتر بود، چون اپل در مسیر رشدی قابلتوجه قرار داشت. بهعلاوه، موفقیت iMac نیز مهر تأییدی بر کیفیت شرکت اپل بود.

امروز، اپل غول دنیای فناوری محسوب میشود و بههمین دلیل، توسعهدهندهها تمایل زیادی به هزینه کردن و تغییر نرمافزارها برای هماهنگی هرچه بیشتر با سختافزار مورد نظر شرکت دارند. البته، امروز اپل کاربران بیشماری هم دارد و جابهجایی آنها به پردازندهی جدید، نیاز به هزینه و زمان زیادی خواهد داشت.

علاوهبر موارد بالا، چالش Xcode هم برای اپل وجود دارد. از سال ۲۰۰۳ که این ابزار در مک عرضه شد، روشی برای همهی توسعهدهندهها بود تا اپلیکیشنهای مخصوص سیستمعاملهای مک، iOS، tvOS و WatchOS را با آن توسعه دهند. ابزار انحصاری اپل، بهنوعی یک ابزار برای ساخت برنامه در همهی پلتفرمهای آنها است که هر کدام خصوصیات منحصربهفرد خود را دارند. امروز کوپرتینوییها سعی میکنند تا قابلیت یکبار کدنویسی و استفاده از اپلیکشین در همهی پلتفرمها را در Xcode بهبود ببخشند.

اپل در رویداد WWDC 2018 نشان داد که چگونه با استفاده از نسخهی بعدی Xcode، اپلیکیشنهای خاصی را از iOS به مک منتقل میکند. آنها سرویسهای Stocks، Home و News را بهعنوان نمونههای اولیهی انتقال بین پلتفرمها نشان دادند. در ادامه اعلام شد که نسخهی مورد نظر از ابزار توسعهای کوپرتینوییها، حاصل تحقیقات چند ساله است و در سال ۲۰۱۹ برای همهی توسعهدهندهها ارائه خواهد شد.

نسخهی بعدی ابزار توسعهدهندگان اپل، بهنام Project Marzipan در داخل شرکت شناخته میشود و هدف اصلی آن، آسانتر کردن توسعهی اپلیکیشن برای مک و iOS است. البته همین ابزار، به تغییر پردازنده به آرم هم کمک میکند. اکنون نیز همهی توسعهدهندههای اپل از سیستم Xcode استفاده میکنند و کوپرتینوییها میتوانند با ایجاد تغییرات در آن، مهاجرت از اینتل را برای توسعهدهندهها سرعت ببخشند.

استیو جابز

صرفنظر از تمام دشواریهایی که تغییر پردازنده از اینتل به آرم بههمراه دارد، میتوان ادعا کرد که اپل قطعا آن را انجام میدهد؛ چون آنها قبلا چند بار کارهای مشابه را انجام دادهاند. اپل تنها شرکت کامپیوتری محسوب میشود که چنان تغییرات عظیمی را در ساختارهای خود بهخوبی پیاده کرد؛ البته، شاید شرکت دیگری هم در تاریخ میماند که چنان تغییراتی را انجام میداد. اگر کامپیوتر NeXT استیو جابز در زمان رونمایی سال ۱۹۸۸ موفق میشد، احتمال آنکه تغییراتی به همین شدت در دههی ۱۹۹۰ شرکت نکست رخ دهد، دور از انتظار نبود.

دلیل آنکه چنان پیشبینی برای نکست بیان میشود، تنها حضور استیو جابز است. او در سال ۱۹۸۸، نظریهای کاملا صحیح دربارهی معماری کامپیوترها و همچنین اپلیکیشنها داشت.

استیو جابز در زمان رونمایی از کامپیوتر نکست ادعا کرد که هر معماری سیستمی، عمری ۱۰ ساله دارد. در ابتدا باید افرادی برای نوشتن اپلیکیشن در معماری مورد نظر پیدا شوند. در مدت ۵ سال، به اوج کاربرد معماری میرسیم و سپس سرازیری سقوط شروع میشود.

بنیانگذار فقید اپل در ادامهی صحبتهای خود گفت که تقریبا در تمام جهان، شرکتها روی فناوری در دسترس خود اصرار میکنند و حتی بهخاطر ترس همراه نشدن مشتریان، فرصتهای جدید بسیاری را از دست میدهند. جابز، نظریههای خود را براساس مدلی میدانست که نکست دربارهی دورهی زندگی کامپیوترها توسعه داده بود. او دربارهی مدل مذکور گفت:

ما تحلیلهای خود را با رخدادهای تاریخی مقایسه کردیم و نتایج دقیقی بهدست آوردیم. با وجود آنکه پس از رسیدن دورهی عمر به نقطهی اوج [عرضهی اپل II] باز هم نمونههای موفق جدیدی عرضه شد، هنوز میتوان نقطهی اوج را همان سال ۱۹۸۲ دانست.

جابز در ادامه به این نکته اشاره کرد که کامپیوترهای IBM با سیستمعامل DOS در سال ۱۹۸۶ به اوج رسیدند و مک نیز در سال ۱۹۸۹، دوران اوج زندگی را تجربه خواهد کرد. او در آن مراسم ایستاد، شرکت جدیدش را تبلیغ کرد و بهدنبال آن بود که اعتباری مشابه روزهایش در اپل بهدست بیاورد. درکنار همهی این موارد، جابز گفت که همهی پیشبینیها برای کامپیوترهای نکست هم رخ خواهد داد. او پیشبینی کرد که نکست، در دههی ۱۹۹۰ نیز به فعالیت ادامه میدهد. او امید داشت که همین صحبتها را در سالهای آینده هم در سالنی برای فروش کامپیوترهای نکست ادامه دهد.

ادامهی مسیر

جابز پیشبینی کرده بود که معماری کامپیوترها، عمر ۱۰ ساله دارد، اما کامپیوتر مک با پردازندهی موتورولا 68000، از سال ۱۹۷۹ تا ۱۹۹۴ و زمان کوچ اپل به پاور پیسی تولید میشد. درواقع، ۱۵ سال عمر آن معماری بود. دربارهی پاور پیسی نیز ۱۱ سال طول کشید تا اینتل جایگزین آن معماری شود. در ادامه نیز اگر پردازندههای اینتل در سال ۲۰۲۰ با نمونههای آرم جایگزین شوند، ۱۵ سال دورهی عمر آنها خواهد بود.

شاید پیشبینی جابز دربارهی دورهی ۱۰ ساله دقیق بوده است و شرکتها، بیش از زمان مورد نیاز به پردازندههای موفق خود اکتفا کردهاند. بههرحال، او دربارهی آنکه اپل باید معماری خود را تغییر دهد، نظری کاملا صحیح داشت و شرکتش نیز تقریبا همیشه در زمان مناسب، تغییرات را ایجاد کرد.

گروهی از پژوهشگران مؤسسهی ولکام سنگر بهصورت جداگانه دستورالعملهای ژنتیکی ۳۰ نوع سرطان را غیرفعال کردند. این امر موجب شناسایی ۶۰۰ نقطهی آسیبپذیر سرطان شد که هرکدام میتواند هدفی برای یک طراحی دارو باشد. پژوهشگران سرطان بریتانیا مقیاس این مطالعه را مورد ستایش قرار دادند.

مطالعه یادشده قاصد آیندهی پزشکی شخصی سرطان است. در حال حاضر داروهایی نظیر داروهای شیمیدرمانی موجود هستند که میتوانند به کل بدن آسیب برسانند. یکی از پژوهشگران این مطالعه، دکتر فیونا بهان است که مادر او پس از اینکه برای دومین بار به سرطان مبتلا شد، درگذشت. انجام اولین دورهی شیمیدرمانی موجب شد قلب او آسیب ببیند بهطوری که ازلحاظ جسمی آنقدر توانایی نداشت که برای بار دوم این درمان را تحمل کند. دکتر بهان در مصاحبه با بیبیسی گفت:

این موضوع بسیار مهم است زیرا در حال حاضر ما سرطان را با درمان کل بدن بیمار درمان میکنیم. ما بهطور اختصاصی سلولهای سرطانی را مورد هدف قرار نمیدهیم. اطلاعاتی که ما در این مطالعه نشان دادهایم، نقاط ضعف کلیدی سلولهای سرطانی را معرفی میکند و به ما اجازه میدهد داروهایی را توسعه دهیم که سلولهای سرطانی را مورد هدف قرار داده و به بافتهای سالم آسیبی نرسانند.

پژوهشگران معتقدند که کار آنها میتواند منجر به توسعهی درمانهای جدید برای سرطان شود

سرطان در اثر بروز جهشهایی درون سلولهای بدن ما اتفاق میافتد که دستورالعملهای DNA ما را تغییر میدهند. جهشها موجب اختلال در عملکرد سلولها میشوند و باعث میشوند این سلولها بهطور غیرقابل کنترلی رشد کنند و در سرتاسر بدن پراکنده شده و درنهایت فرد بیمار را از پای درآورند. پژوهشگران در پژوهشی بزرگ، هرکدام از دستورالعملهای ژنتیکی داخل سرطان را غیرفعال کردند تا ببینند که کدام دستورها برای بقای تودهی سرطانی حیاتی هستند. آنها بهطور جداگانه حدود ۲۰ هزار ژن را در بیش از ۳۰۰ تومور رشدیافته در آزمایشگاه که شامل ۳۰ نوع سرطان مختلف میشد، غیرفعال کردند.

مقالههای مرتبط:

آنها از تکنیک کریسپر استفاده کردند (همان تکنیکی که سال گذشته دانشمندان چینی برای ویرایش ژن دو نوزاد استفاده کرده بودند). کریسپر ابزاری نسبتا جدید، آسان و ارزان برای دستکاری DNA است و انجام این مطالعه در حدود یک دهه پیش غیرممکن بود. در این پژوهش که در مجلهی Natureمنتشر شد، ۶۰۰۰ ژن مهم که حداقل یک نوع از سرطانها برای بقا به آن نیاز داشت، شناسایی شد. البته برخی از آنها از آنجایی که برای سلولهای سالم نیز حیاتی بودند، گزینهی مناسبی برای توسعهی داروهای ضدسرطانی نبودند.

پژوهشگران دیگری نیز قبلا داروهای دقیقی مانند هرسپتین را برای درمان سرطان سینه توسعه دادهاند و پژوهشگران مطالعهی حاضر میگویند این دارو شاهدی بر این موضوع است که روش آنها نتیجه خواهد داد. البته هنوز کار زیادی برای رسیدن به توسعه دارو پیش رو است و پژوهشگران فهرست کوچکتری مشتمل بر ۶۰۰ هدف را برای توسعه داروها معرفی کردهاند.

یکی از اهداف مهم در این زمینه ژن WRN است. پژوهشگران متوجه شدند که این ژن برای بقای برخی از انواع سرطان حیاتی است. ژن WRN نقشی حیاتی در حدود ۱۵ درصد از سرطانهای کولون و ۲۸ درصد از سرطانهای معده دارد ولی هنوز دارویی که بتواند این ژن را مورد هدف قرار دهد، طراحی نشده است.

این پژوهش حاصل همکاری مؤسسهی سنگر، آزمایشگاه زیستشناسی ملکولی اروپا و شرکت دارویی GSK است و همهی یافتههای آن در دسترس عموم قرار گرفته است. هدف نهایی این پژوهش آن است که برای تمام انواع سرطانها، یک «نقشهی وابستگی سرطان» تهیه شود. در این صورت پزشکان قادر خواهند بود که تومور بیماران را آزمایش کرده و براساس نوع آن برای بیماران ترکیب دقیقی از داروهایی را تجویز کنند که سلولهای سرطانی را نابود کنند. دکتر بهان به بیبیسی گفت:

ما در حال درک این موضوع هستیم که در سلولهای سرطانی چه چیزی اتفاق میافتد بنابراین میتوانیم اسلحهی خود را بهسوی سلولهای سرطانی بگیریم و نه مانند روش شیمیدرمانی کل بدن را مورد هدف قرار دهیم. این نخستین قدم برای قرار دادن یک چشم لیزری در سلاح پزشکی ما است.

کارن ووسدن، از دانشمندن ارشد مؤسسهی پژوهش سرطان بریتانیا میگوید:

چیزی که موجب قدرت این مطالعه میشود، مقیاس آن است. این کار نقاط شروع بسیار عالی را فراهم میکند و مرحلهی بعدی تجزیهوتحلیل کامل ژنهایی است که بهعنوان نقاط ضعف سرطان شناسایی شدهاند تا تعیین کنند که آیا آنها میتوانند روزی به توسعهی درمانهای جدیدی برای بیماران کمک کنند؟

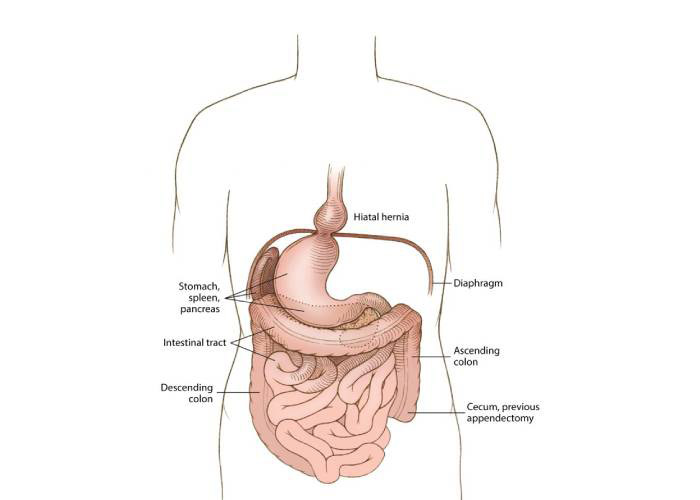

قلب در جای درستش قرار داشت؛ اما تقریبا تمام دیگر اعضای بدن رز ماری بنتلی، زن اورگنی که در سن ۹۹ سالگی از دنیا رفت، در جای صحیح خود قرار نگرفته بودند. موضوع شگفتآور اینکه وقتی این مادر دوستداشتنی و صاحب یک فروشگاه مواد غذایی حیوانات خانگی در سال ۲۰۱۷ از دنیا رفت، کسی درمورد وضعیت عجیب و باورنکردنی او خبر نداشت. نه ۵ فرزندنش و نه حتی خود رز نیز از وضعیت غیرعادی درون بدن خود خبر نداشت.

فقط یک بار پزشک در یافتن محل آپاندیس او دچار مشکل شد. اما در سال ۲۰۱۸، وقتی دانشجویان پزشکی دانشگاه علوم و بهداشت اورگن برای درس آناتومی خود، تشریح جسد بنتلی را آغاز کردند، نخستین کسانی بودند که از راز مهم بنتلی آگاه شدند. بنتلی جسد خود را برای علم اهدا کرده بود و وقتی دانشجویان به درون بدن او نگاه کردند، وضعیت شگفتآوری دیدند: طرح هر کدام از اعضای بدن او تصویر آینهای آناتومی یک انسان معمولی بود.

نمایشی از وضعیت جابهجایی اندام (سیتوس اینورسوس) در بنتلی

معدهاش در سمت راست بدن قرار گرفته بود و کبدش که باید بهطور طبیعی در سمت راست بدن قرار میگرفت، در سمت چپ بدنش دیده میشد. به همین ترتیب، طحال و دیگر اندامهای داخل شکمش درون قفسهی سینه جای گرفته بودند و بینظمیهای زیاد دیگری نظیر فتق هیاتال و طیفی از ناهنجاریهای وریدی نیز در بدن او به چشم میخورد. کم واکر، متخصص آناتومی در دانشگاه اورگن میگوید:

متوجه شدم که اتفاق عجیبی افتاده بود اما مدتی زمان برد تا دریابیم اعضای بدن او چگونه کنار هم قرار گرفتهاند.

علت این آشفتگی درون بدن بنتلی، یک مشکل مادرزادی بهنام سیتوس اینورسوس بود که برآورد میشود از هر ۲۲۰۰۰-۱۰۰۰۰ تولد، در یک نفر دیده شود. اما مورد بنتلی کمیابتر هم بود. بهعلت پیامدهای سلامتی مرتبط با بینظمی در موقعیت اندامها، بسیاری از افراد مبتلا به سیتوس اینورسوس نهایتا تا دوران کودکی زنده میمانند و این مورد در متون پزشکی اغلب بهصورت «اتوپسی که در بیماران بسیار جوان دیده میشود»، تشریح میشود. اما بنتلی با وجود داشتن این وضعیت باورنکردنی و مرگبار درون بدنش، در طول زندگی خود وضعیت سلامتی مناسبی داشت و در سن ۹۹ سالگی به دلایل طبیعی از دنیا رفت.

رز ماری بنتلی

براساس نظر پژوهشگران، این ترکیب تغییرات آناتومیکی، او را در دستهی یک درصدی (یا کمتر) مبتلایان به سیتوس اینورسوس قرار میدهد و بهطور کلی احتمال رسیدن چنین فردی به دوران بزرگسالی حدود یک در ۵۰ میلیون است. واکر در مصاحبهای با CNN گفت:

من تصور میکنم که احتمال یافتن فرد دیگری نظیر بنتلی چیزی حدود یک در ۵۰ میلیون باشد. فکر میکنم که هیچکدام از ما هیچگاه او را فراموش نخواهیم کرد.

این امر برای دانشجویان پزشکی نیز صادق بود. زیرا آنها با مطالعهی نمونهی بینظیر بنتلی مطالب زیادی آموختند. وارن نیلسن، یکی از این دانشجویان گقت:

بسیار شگفتانگیز بود. ما توانستیم نهتنها آناتومی طبیعی را یاد بگیریم بلکه همچنین درمورد تغییرات آناتومیکی که ممکن است پیش آید، مطالب زیادی آموختیم.

سن بالای بنتلی در هنگام مرگش، او را به ماندگارترین فرد مبتلا به سیتوس اینورسوس تبدیل کرد. او قطعا مسنترین فرد شناختهشدهی مبتلا به این بیماری در علم است: قبل از او، مسنترین بیمار مبتلا به این عارضه توانسته بود تا ۷۵ سالگی زندگی کند؛ یک ربع قرن کمتر از بنتلی.

برای فردی که قبلا آرایشگر بود و در جریان جنگ جهانی دوم نیز بهعنوان پرستار داوطلب فعالیت کرد، این موضوع، یادداشت شگفتانگیزی بر آگهی فوتش است. فردی علاقمند به علم که حتی بدنش را پس از مرگ در اختیار علم گذاشت.

در قسمت اول گزارش زنان موفق ایرانی، زنانی را که با موفقیت و پشتکار به آرزوهایشان جامه عمل پوشانده بودند و در خارج از ایران موفق بودند را معرفی کردیم اکنون در این قسمت قصد داریم بانوانی را که بخشهای گوناگون غولهای فناوری دنیا را مدیریت میکنند، معرفی کنیم.

به گزارش ایسنا، زنان در سراسر جهان با وجود تمام مشکلات و چالشهایی که دارند اما دست از رویاها و اهداف خود نمیکشند و برای مفید بودن و داشتن فردایی درخشان تلاش میکنند. در میان تمام زنان جهان، زنهایی بودند و هستند که با تمام سختیهایی که مواجه هستند گامهای خود را محکم و نیرومند برمیدارند و با تمام قوا برای اثبات جمله "ما زنان میتوانیم" تلاش میکنند.

۱. "پریسا تبریز" (Parisa Tabriz )

پریسا تبریز یک متخصص امنیت رایانه ایرانی- لهستانی است. وی در سال ۱۹۸۳ متولد شد و در حومه شهر شیکاگو، ایلینوی بزرگ شده است. پریسا تبریز فرزند یک پزشک ایرانی و پرستاری لهستانی است. تبریز ابتدا برای تحصیل در رشته مهندسی وارد "دانشگاه ایلینوی در اربانا-شمپین"(University of Illinois at Urbana–Champaign) شد اما مدتی بعد نظرش تغییر کرد و به علم کامپیوتر علاقه مند شد. او دارای مدرک کارشناسی و کارشناسی ارشد مهندسی علوم کامپیوتر از "دانشگاه ایلینوی" است. پریسا تبریز در سال ۲۰۰۷ به استخدام شرکت گوگل درآمد و تا سال ۲۰۱۱ مدیر و متخصص امنیت در این شرکت بود که بعدها گسترش یافت و هماکنون بیش از ۲۵۰ متخصص امنیت در آن مشغول هستند و اکنون ریاست بخش مهندسی مرورگر گوگل کروم را بر عهده دارد. بخشی که وی ریاست آن را بر عهده دارد، از ۳۰ هکر در اروپا و آمریکا تشکیل شده و وظیفه بررسی تهدیدات امنیتی مرتبط با موتور جستجوی گوگل و همینطور دیگر محصولات این شرکت، از جمله مرورگر گوگل کروم را بر عهده دارند. نکته قابل توجه و مهمی که این زن ایرانی را نامی و مطرح کرده است این است که شرکت گوگل به او لقب "شاهزاده امنیت" را داده است. نشریه "فوربس" در سال ۲۰۱۲ از پریسا تبریز به عنوان یکی از ۳۰ چهره برتر در زمینه تکنولوژی، در کنار افرادی چون "مارک زاکربرگ" مؤسس فیسبوک نام برده است. یکی از اهداف پریسا این است که زنان بیشتر وارد این رشته شوند و در محل کار خود نیز تمام تلاش خود را میکند تا بیشتر زنان در آنجا مشغول به کار شوند. تبریز علاوه بر فعالیتش در گوگل یک مدرس نیز است و هر سال در یک کنفرانس علمی سالانه در لاسوگاس برای نوجوانان کلاسهایی برگزار میکند و طی آن درباره رشته و فعالیت خود اطلاعاتی را در اختیار انها میگذارد.

۲. "ماریا خرسند"(Maria Khorsand)

ماریا خرسند دانشمند رایانه و مدیر ارشد اجرایی ایرانی اهل سوئد است. او متولد ۱۲ ژوئن ۱۹۵۷ در ساری است. ماریا سال ۱۹۵۷ به همراه پدر و مادرش به لس آنجلس مهاجرت کرد. او مدرک کارشناسی ارشد خود در رشته علوم رایانه را از "دانشگاه ایالتی کالیفرنیا در فولرتون"(California State University - Fullerton) اخذ کرد. او در مدتی که مدیرعامل شرکت اریکسون در سوئد بود، موفق شد به یکی بنیانگذاران فناوری بلوتوث بدل شود. خرسند مدتی مدیریت تولید سختافزار شرکت "دل" در سوئد را نیز بر عهده داشت اما در حال حاضر وی مدیر اجرایی شرکت"SP Sveriges Tekniska Forskningsinstitut" در سوئد است. خرسند از سال ۲۰۱۰ عضو هیئت مدیره شرکت "بیجر الکترونیک"(Beijer Electronics) نیز است. شرکت الکترونیکی بیجر شرکتی است که طراحی و ساخت پایانههای رابط کاربری و نرم افزار اتوماسیون را بر عهده دارد.

۳. "ریحانه صفوی نائینی"(Reihaneh (Rei) Safavi-Naini)

"ریحانه صفوی نائینی" رئیس گروه امنیت اطلاعات در "دانشگاه کالگری"(University of Calgary) است. وی دارای مدرک کارشناسی و کارشناسی ارشد رشته مهندسی برق از "دانشگاه تهران" است. او پس از اخذ مدرک کارشناسی ارشد خود برای ادامه تحصیلات به خارج از کشور مهاجرت نمود و پس از آن مدرک دکترای خود در رشته مهندسی برق نظریه کدگذاری را از "دانشگاه واترلو"(University of Waterloo) کانادا اخذ کرد. پیش از آنکه وی در سال ۲۰۰۷ رئیس گروه امنیت اطلاعات "دانشگاه کالگری" شود، استاد علوم رایانه دانشکده انفورماتیک "مؤسسه تحقیقات فناوری اطلاعات و ارتباطات دانشگاه ولونگونگ"(University of Wollongong) استرالیا بود. نائینی در برنامهها و کنفرانسهای مهم علمی رمزنگاری و امنیت اطلاعات از جمله CRYPTO ،EUROCRYPT، ASIACRYPT و ACM CCS نقش مهمی را ایفا کرده است. در حال حاضر، او علاوه بر سمت ریاست گروه امنیت اطلاعات "دانشگاه کالگری" ، مدیر "آزمایشگاه امنیت اطلاعات iCORE " نیز است.

۴. "لیلی بقایی راد"(Leili Baghaei Rad)

"لیلی بقایی راد" دارای مدرک کارشناسی مهندسی برق از " دانشگاه کانتربری"(University of Canterbury) و مدرک کارشناسی ارشد مهندسی برق از "دانشگاه آیداهو"(University of Idaho) ایالات متحده آمریکا است. لیلی علاوه بر مدرک دکترای مهندسی برق از "دانشگاه استنفورد"(Stanford University) دارای گواهی کارآفرینی از "دانشکده بازرگانی استنفورد" نیز است. "لیلی بقایی راد" به مدت ۲ سال و طی سالهای ۲۰۱۳ تا ۲۰۱۵ مدیر محصول شرکت گوگل بود. وی از سال ۲۰۱۵ تا سال ۲۰۱۸ مدیر ارشد محصول در فیس بوک بود و در آنجا به بهبود و پیشرفت فناوری ویدئوی زنده و جستجوی رسانه متمرکز بود اما در حال حاضر وی مدیر ارشد محصول در "اینستاگرام" است. لیلی علاوه بر علاقهمندی به کار در شرکتهای بزرگی مانند "فیسبوک" و "گوگل"، به کارآفرینی اجتماعی نیز علاقمند است. او امیدوار است تا یک روز عشق و محبت خود را نسبت به تکنولوژی و کارآفرینی ترکیب کند و یک کسب و کار نوین در جهت کمک به رشد و توسعه کودکان به حداکثر توانایی خود، بویژه در خانوادههای فقیرنشین ایجاد کند.

۵. "ژینا پروانه کُدی"(Gina Parvaneh Cody)

"ژینا پروانه کُدی" مهندس و کارآفرین ایرانی- کانادایی است. کدی سال ۱۹۵۷ در ایران متولد شد. در سال ۱۹۷۸، کدی مدرک کارشناسی خود در رشته مهندسی ساختمان را از "دانشگاه صنعتی شریف" اخذ کرد. در سال ۱۹۷۹ او ایران را به قصد تحصیل مقطع کارشناسی ارشد در کانادا ترک کرد. در آنجا وی موفق به اخذ مدرک کارشناسی ارشد مهندسی برق از "دانشگاه کنکوردیا"(Concordia University) شد. پس از کارشناسی ارشد وی موفق به دریافت مدرک دکترای مهندسی ساختمان از "دانشگاه کنکوردیا " شد. ژینا پروانه کُدی نخستین زنی بود که موفق به اخذ مدرک دکترای مهندسی ساختمان از این دانشگاه شد. دکتر کدی در حال حاضر عضو شورای حکام، کمیته مدیریت و رئیس کمیته برنامه ریزی املاک و شورای صنعتی دانشگاه کنکوردیا است. در سال ۲۰۱۸، دکتر کدی مبلغ ۱۵ میلیون دلار به دانشکده مهندسی و علوم کامپیوتر "دانشگاه کنکوردیا" اهدا کرد. به افتخار موفقیتهای بسیار و سخاوت او، نام دانشکده مهندسی کامپیوتر و علوم کامپیوتر این دانشگاه را به نام او یعنی دانشکده "ژینا کُدی" تغییر نام دادند. این نخستین دانشکده مهندسی در کانادا و یکی از اولین مؤسسات بینالمللی است که به نام یک زن نامگذاری شده است.

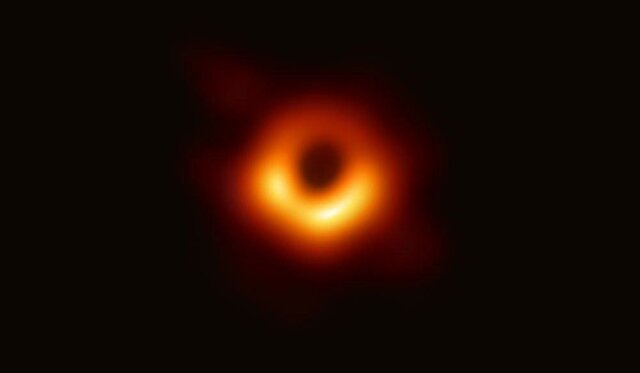

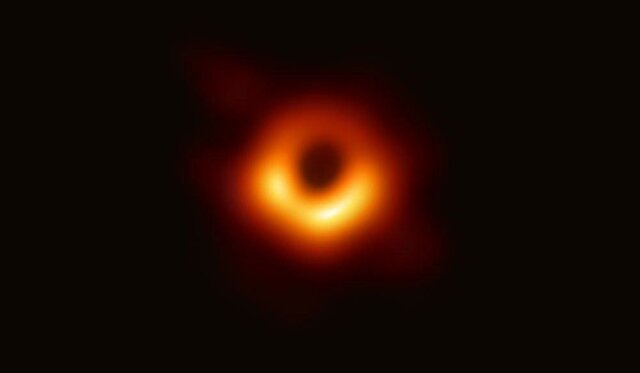

مجری طرح رصدخانه ملی ایران درباره اهمیت رصد سیاهچاله "Pōwehi"و تصویربرداری از آن گفت: نخست اینکه یک قرن بعد از پیشبینی سیاهچاله، رصد آن انجام شد. چیزی که حتی خود "انیشتین" هم در مورد وجودش تردید داشت. یعنی برخلاف آنچه محاسبات نشان میداد فکر میکرد طبیعت اجازه تشکیل چنین جسم با این ماهیت عجیب را ندهد. حال با این رصد میدانیم که سیاهچاله یک نظریه یا تخیل نیست بلکه یک واقعیت است.

به گزارش ایسنا، در اواخر هفته گذشته و در ۲۱ فروردین ماه، رویدادی بینظیر در نجوم به وقوع پیوست و دانشمندان که سالیان متمادی برای ثبت یک تصویر از سیاهچاله تلاش میکردند، بالاخره موفق شدند. اختر شناسان برای نخستین بار در تاریخ، تصویری از یک سیاهچاله را که اکنون نام آن را "Pōwehi" نامیدهاند با دوربین تلسکوپ "افق رویداد" شکار کنند. نام این سیاهچاله در زبان هاوایی به معنای "منبع تاریکی زینت داده خلقت بی پایان" (embellished dark source of unending creation) است.

سیاه چاله Pōwehi چهل میلیارد کیلومتر قطر داشته و در یک کهکشان دور قرار دارد. اکنون بشر به لطف تلسکوپ "افق رویداد" قادر به دیدن نخستین تصویر از افقِ رویدادِ یک سیاه چاله که در ۵۰۰ میلیون تریلیون کیلومتری کرهزمین قرار دارد است.

بدون شک سیاهچالهها یکی از پدیدههای بسیار جذاب و هیجانانگیز و در عین حال اسرارآمیز جهان هستند. این پدیده همچنین برای اخترشناسان و اختر فیزیکدانان نیز بسیار اسرارآمیز است و به همین دلیل است که آنها حدود نیم قرن است که در حال مطالعه درباره آنها هستند.

دکتر حبیب خسروشاهی یکی از اختر فیزیکدانان ایرانی و مجری طرح رصدخانه ملی ایران در گفتوگو با ایسنا با بیان اینکه سیاهچاله یک جسم فشردهی پُرجرم است در این رابطه گفت: به بیان ساده اگر ابعاد یک جسم از افق رویداد آن کوچکتر باشد عملاً سیاهچاله است. سیاهچاله از نظر فیزیکی یا بهتر بگویم اختر فیزیکی جسمی است که حتی نور هم نمیتواند از آن بگریزد. چرا پای نور را وسط میکشیم؛ چون نور بالاترین سرعت را دارد. پس اگر نور نتواند از محیطی خارج شود عملاً هیچ اطلاعی از وضعیت داخلی آن جسم یا محیط نخواهیم داشت!

وی درباره محاسبه افق رویداد گفت: برای همه اجرام مانند سیارات و ستارهها میتوان سرعت فرار تعریف کرد. مثلاً سرعت فرار از زمین ۱۱۰۰۰ متر بر ثانیه است. یعنی اگر جسمی را با این سرعت به آسمان پرتاب کنیم از جاذبه گرانشی زمین خارج میشود و دیگر بر نمیگردد. جاذبه گرانشی اجرام با افزایش فاصله از آنها کاهش مییابد. به همین ترتیب میتوان برای هر جسم فشردهای افق رویداد تعریف کرد که فاصلهای از آن جسم است که حتی نور که بیشترین سرعت را دارد نتواند از آن فرار کند. افق رویداد یعنی کمترین فاصلهای که اگر در آن اتفاقی بیفتد ما آن را نمیفهمیم. حال اگر تمام جرم خورشید در یک سطحی که کمتر از سه کیلومتر بود جمع میشد دیگر خورشید را نمیدیدیم چون چنین اتفاقی رخ نداده و خورشید بزرگتر از سه کیلومتر است پس سیاهچاله نیست چرا که سیاهچاله، هم باید پُرجرم باشد و هم فشرده. افق رویداد سیاهچاله مرکزی کهکشان راه شیری حدود هفت میلیون کیلومتر و افق رویداد سیاهچاله پُر جرم کهکشان M87 حدود ۲۰ میلیارد کیلومتر است. به خاطر داشته باشیم که ما در مورد خود سیاهچاله و ساختار داخلی آن چیزی نمیدانیم! پس همه چیز در داخل افق رویداد سیاهچاله مبهم است.

این استاد و پژوهشگر اخترفیزیک دانشگاه «بیرمنگام» درباره رصد افق رویداد اظهار کرد: از آنجایی که مشاهده سیاهچاله به دلیل عدم انتشار نور یا امواج الکترومغناطیسی غیر ممکن است تنها تابش اطراف آن سیاهچاله که به دلیل دمای بالای ناشی از دیسک برافزایشی است قابل مشاهده است که یقیناً در شعاعی بزرگتر از افق رویداد است. دیسک بر افزایشی ناحیهای است که گاز و ستارهها با نزدیک شدن به سیاهچاله با سرعت و به صورت چرخشی در آن به سمت سیاهچاله سقوط میکنند. برای اینکه بتوانیم افق رویداد یک سیاهچاله (یا عملاً دیسک بر افزایشی) را مشاهده یا ثبت کنیم باید تلسکوپی داشته باشیم که بتواند ابعاد حدود ۲۰ میلیارد کیلومتر (معادل ۱۳۴ واحد نجومی) را در فاصلهای حدود ۵۵ میلیون سال نوری رصد کند! نسبت فاصله جسم به ابعاد جسم حدود ۱۰ میلیارد است! به عبارت دیگر باید تلسکوپی داشته باشیم که توان آن از مرتبه ۱۰ میکرو ثانیه قوسی باشد. هر ثانیه قوسی ۳۶۰۰ ام یک درجه است.

وی ادامه داد: توان بهترین تلسکوپهای رادیویی موجود با قطر آرایه چند کیلومتر حدود ۱۰۰۰ برابر کمتر از میزان مورد نیاز برای رصد افق رویداد یک سیاهچاله "ابرجرم" در این فاصله است!

پردازش تصاویر دو سال طول کشیده است

دکتر خسروشاهی با بیان اینکه مجموعهای از تلسکوپهای رادیویی برای تصویربرداری از این سیاهچاله در نقاط مختلفی از زمین مستقر شده بودند گفت: تصویربرداریها از این سیاهچاله توسط تلسکوپ رادیویی انجام گرفته است. مجموعهای از تلسکوپهای رادیویی در هشت نقطه مختلف کرهزمین انتخاب شدند و فواصل این تلسکوپها از هم به اندازهای بوده که بتوان تلسکوپی به اندازه قطر کرهزمین داشته باشیم. دقت زاویهای یکی از این تلسکوپها به تنهایی حدود ۱۰۰۰ برابر کمتر از آن میزانی بوده که برای تصویربرداری مورد نیاز بود، بنابراین تلسکوپهایی که در یک طول موج کار میکردند در اسپانیا، هاوایی، آریزونا، مکزیک و آرایه تلسکوپهای "آلما" که در شیلی برای این منظور انتخاب شدند. همهی این تلسکوپها با هم از یک هدف یعنی همان سیاه چاله M87 تصویر برداری کردند که بعدتر در فرآیند پردازش دادهها این تصاویر با هم همزمان شدند. در شیلی و هاوایی دو تلسکوپ قرار داشته و از آنجایی که این دو تلسکوپ نزدیک به یکدیگر قرار داشتند یکی در نظر گرفته شدند.

وی درباره لزوم همزمانی تصویر برداری تلسکوپها گفت: اما چالش اصلی همزمان کردن این تلسکوپها بود چراکه برای ثبت تصویر با این دقت زاویه باید تلسکوپهای این شبکه همزمان امواج منتشر شده از اطراف سیاهچاله را ثبت میکردند. برای این کار از ساعتهای اتمی همزمان شده با دقت ۱ ثانیه به ازای ۱۵ میلیارد سال استفاده شده است. این رصد آوریل ۲۰۱۷ انجام گرفته ولی پردازش دقیق آن دو سال به طول انجامیده است. به هر حال به دلیل حجم بالای دادهها و انتقال آنها و به با توجه به اینکه انتقال این حجم از اطلاعات به طریق دیجیتال و از طریق اینترنت غیر ممکن بوده است. به طور مثال دادههای قطب جنوب را بعد از تمام شدن زمستان انتقال دادند و بعد از تحلیل و شبیهسازی مطمئن شدند که اندازهگیریها درست بوده است یا نه. از سوی دیگر با توجه به چرخش زمین و اثراتی که میتواند در کاهش شفافیت دادهها داشته باشد نیاز به آنالیز دقیقتر و برهم نهی دقیق دادهها و تصاویر و از بین بردن آثار غیر واقعی مانند چرخش زمین مستلزم زمان بود.

این استاد پژوهشگاه دانشهای بنیادی در ادامه اظهار کرد: به بیان دیگر با توجه به میزان فاصله زمین تا این کهکشان، میتوان اینگونه گفت که این تصویر در اصل به وضعیت سیاهچاله در ۵۵ میلیون سال پیش بر میگردد، چون فاصلهی ما از این کهکشان ۵۵ میلیون سال نوری است.

وی درباره میزان تغییر این سیاهچاله در طول ۵۵ میلیون سال گذشته گفت: سیاهچاله جسمی است که در حال تحول است و تصاویری که ۲ سال پیش ثبت شده است نیز نشان از تغییرات زمانی دارد. البته نمیتوانیم انتظار داشته باشیم که تغییر زیادی کرده باشد. مثلاً شما به هر قسمت سطح خورشید نگاه کنید تحول خاصی در آنجا رخ میدهد اما خورشید به طور کلی تغییری نکرده است. تغییرات روزانه و سالانه وجود دارد ولی سیاهچاله به معنی خود سیاهچاله و ابعاد رویدادش و افق رویدادش به نظر نمیآید که در زمان کوتاه تغییر کند. زمان ما یعنی ساعتها، سالها و قرنها در مقایسه با اتفاقاتی که در مقیاس کیهانی میافتد بسیار ناچیز هستند. هر چند که رصدهای بعدی نشان خواهد داد تغییرات سالانه و چند ده سالهی یک سیاهچاله چه خواهد بود و این سوالی است که محققان به پاسخ آن علاقمند هستند.

مجری طرح رصدخانه ملی ایران درباره تجمیع عکسهای گرفته شده از این سیاهچاله توسط تلسکوپهای مختلف گفت: هر کدام از تصاویری که مجزا گرفته شده نمیتواند به تنهایی این تصویر فعلی را به ما بدهد. باید توجه داشت که این تجمیع عکسها به این معنی نیست که مثلاً یک تلسکوپ از یک کهکشان عکس بگیرد و یک تلسکوپ دیگر هم از همان کهکشان عکس بگیرد و ما اینها را روی هم بگذاریم تا عکس واضحتر دیده شود. هیچیک از این تلسکوپها به تنهایی قادر نیست که افق رویداد یعنی همان سیاهی وسط تصویر را نشان دهد. یعنی یک تصویر کاملاً محو نشان میدهند که هیچچیز در آن نیست. در اصل وقتی تصاویر با هم ترکیب میشود به این تصویر نهایی با این توان تفکیک زاویهای میرسیم.

وی ادامه داد: به عبارت دیگر این تلسکوپها همزمان یک تلسکوپ هستند. تلسکوپها امواج الکترومغناطیسی یا نور را در یک جا جمع میکنند. یعنی هرچه قطر یک تلسکوپ بیشتر باشد سیگنال بیشتری دریافت میکند. یکی دیگر از کارهای تلسکوپها تفکیک زاویهای اجرام در آسمان است؛ پس علت علاقمندی منجمان به افزایش قطر دهانه تلسکوپها فقط افزایش قدرت تجمیع نور نیست بلکه هرچه قطر دهانه تلسکوپ افزایش یابد میتواند اجرام نزدیک به هم را از هم تفکیک کند. در این مورد حتی تلسکوپی با قطر چند کیلومتر هم نمیتواند افق رویداد این سیاه چاله را مشاهده کند. تقریباً برای این کار هزار برابر دقتش کم است. یعنی تمام این تلسکوپها را برای این استفاده نمیکنیم که قدرت یکی از تلسکوپها به اندازه کافی نیست، بلکه به این دلیل از هشت تلسکوپ استفاده میکنیم که تفکیک زاویهای تلسکوپها را افزایش دهیم برای همین است که این تلسکوپها باید در مکانهای مختلف زمین و حتیالمکان از هم دور باشند.

مجری طرح رصدخانه ملی ایران درباره تلسکوپ افق رویداد گفت: تلسکوپ افق رویداد خود یک تلسکوپ به معنای کلاسیک یک تلسکوپ نیست بلکه یک شبکه تلسکوپ است که اسمش را افق رویداد گذاشتهاند. این تلسکوپ آن قدر تفکیک زاویهای را در آسمان افزایش میدهد که بتوانند افق رویداد یک سیاهچاله را رصد کنند.

اهمیت رصد این سیاهچاله چیست؟

این اختر فیزیکدان ایرانی درباره اهمیت رصد این سیاهچاله و تصویربرداری از آن گفت: نخست اینکه یک قرن بعد از پیشبینی سیاهچاله، رصد آن انجام شد. چیزی که حتی خود "انیشتین" هم در مورد وجودش تردید داشت. یعنی برخلاف آنچه محاسبات نشان میداد فکر میکرد طبیعت اجازه تشکیل چنین جسم با این ماهیت عجیب را ندهد. حال با این رصد میدانیم که سیاهچاله یک نظریه یا تخیل نیست بلکه یک واقعیت است. تمام شواهد پیشین سیاهچالهها غیر مستقیم بود. برای مثال تلسکوپهای بزرگ فعلی کلاس هشت متر توانسته بودند از روی سرعت حرکت ستارههای اطراف سیاهچاله مرکزی کهکشان راه شیری به وجود آن و میزان جرم آن پی ببرند اما هیچگاه تصویری از آن نداشتند. این رصد همچنین تأیید مهمی بر ویژگیهای دیسک گازی و ستارهای اطراف سیاهچاله است. تصاویر ثبت شده در زمانهای مختلف نشان میدهد که سیاهچالهها اجرام در حال تحول هستند.

خسروشاهی ادامه داد: مطالعات بعدی میتواند روی مسائلی چون وجود میدان مغناطیسی اطراف سیاهچاله یا روی موضوعاتی چون وجود آثار میدان مغناطیسی بر افق رویداد باشد. یادمان باشد که این مورد خاص، سیاهچالهای است که تابش رادیویی و ایکس ری دارد. این سیاهچاله بسیار پرجرم است. هیچکس تاکنون تصویری از اطراف سیاهچاله و از خود سیاهچاله نگرفته است. سوالاتی از قبیل اینکه میدان مغناطیسی این سیاهچاله و میزان چرخشش به چه شکلی است؟ اینها سوالاتی است که بدون شک در آینده ما را با حجم زیادی از تحقیقات مواجه میکند. از طرف دیگر بهبود فنی تلسکوپ این امکان را فراهم خواهد کرد که منجمان دنبال سیاهچالههای بیشتری در اطراف بخش مرکزی کهکشان راه شیری باشند.

پروژه تصویربرداری از سیاهچاله دو دهه پیش آغاز شده بود

این استاد پژوهشگاه دانشهای بنیادی درباره زمان آغاز پروژه تصویربرداری از این سیاهچاله گفت: پروژه اتصال تلسکوپها که به طور مفهومی تلسکوپ افق رویداد است دو دهه پیش کلید خورده است و در سالهای گذشته هم شواهدی مبنی بر اینکه این تلسکوپ قادر است به افق رویداد نزدیک شود منتشر شد ولی هیچ گاه تصویری با این دقت و کیفیت در اختیار منجمان قرار نگرفته بود.

وی درباره توانایی تلسکوپ رصدخانه ملی ایران برای رصد چُنین اشیایی گفت: هر تلسکوپی برای طول موج خاص و موضوع علمی خاص طراحی و ساخته میشود. تلسکوپ ۳.۴ متری رصدخانه ملی ایران تلسکوپی نیست که چنین کاربری داشته باشد، اما چیزی که تلسکوپ رصدخانه ملی ایران میتواند مطالعه کند ویژگی ستارههایی است که در پیرامون سیاهچاله مرکزی کهکشان راه شیری در حال حرکت هستند و این کار از طریق اندازهگیری سرعت بخشی ستارهها در مرکز کهکشانها انجام میشود.

سرعت حرکت ستارهها دلیلی بر وجود سیاهچاله

این پژوهشگر گروه تحقیقات کهکشانهای فسیلی دانشگاه بیرمنگام در ادامه حرکت ستارهها را از جمله نشانههای وجود سیاهچاله دانست و افزود: یکی از دلایلی که ما فکر میکردیم چنین سیاهچالهای در کهکشانها وجود دارد به خاطر سرعت بخشی ستارههای این سیاهچاله مرکزی است. این ستارهها جنبوجوش بیشتری از آنچه انتظار داریم دارند از همین موضوع نتیجه میگیریم که احتمالاً یک سیاهچاله پرجرمی وجود دارد.

خسرو شاهی ادامه داد: در مورد کهکشان راه شیری هم همین اتفاق افتاد یعنی از حرکت ستارهها و مدار یابی ستارهها در اطراف سیاهچاله مرکزی خودمان فهمیدیم سیاهچالهای به جرم حدود ۲.۳ میلیون جرم خورشید در کهکشان ما وجود دارد. اما تاکنون افق رویداد این سیاهچاله رصد نشده است.

مجری طرح رصدخانه ملی ایران در پایان در پاسخ به سوالی درباره دلایل میزان دشواری تصویربرداری از یک سیاهچاله گفت: در انتخاب سیاهچاله برای اندازهگیری افق رویداد، سبک-سنگین کردن فاصله سیاهچاله از ما و ابعاد افق رویداد مهم است. هر چه سیاهچاله پُر جرمتر باشد افق رویداد بزرگتری دارد و رصد آن سادهتر است اما این امر بستگی به فاصله نیز دارد. با وجود اینکه رصد افق رویداد سیاهچاله مرکزی کهکشان راه شیری نیز در دستور کار است اما دانشمندان به این نتیجه رسیدند که سیاهچاله M87 مورد خوبی است. اگر چنین سیاهچالهای به همین جرم در فاصله کمتر از این وجود داشته باشد قطعاً برای رصد مناسب خواهد بود.

بر اساس تصمیم شورای سنجش و پذیرش، آزمون کارشناسی ارشد ناپیوسته سال ۹۸ به تعویق افتاد و در تاریخ های ۲۳ و ۲۴ خرداد ماه سال جاری برگزار خواهد شد.

به گزارش ایسنا، بر اساس تصمیم صبح امروز شورای سنجش و پذیرش، آزمون کارشناسی ارشد ناپیوسته سال ۹۸ به دلیل وقوع سیل در برخی نقاط کشور و عدم آمادگی داوطلبان با حدود ۷ هفته تأخیر و در روزهای پنج شنبه ۲۳ و جمعه ۲۴ خرداد ماه سال جاری در حوزههای امتحانی برگزار خواهد شد.

این تصمیم در حالی در جلسه امروز شورای سنجش و پذیرش اتخاذ شد که بیش از این سازمان سنجش آموزش کشور در اطلاعیهای با تعویق زمان برگزاری آزمون کارشناسی ارشد سال ۹۸ مخالفت و اعلام کرده بود " نظر به اینکه فرایند اجرایی آزمون مذکور طولانی بوده و میبایست به نحوی برنامهریزی شود که نتایج نهایی در اوایل شهریورماه اعلام شود، لذا آزمون مطابق برنامهزمانبندی اعلام شده قبلی در روزهای پنجشنبه ۹۸/۰۲/۰۵ و جمعه ۹۸/۰۲/۰۶ برگزار خواهد شد و اطلاعیه این سازمان در خصوص حوزههای برگزاری، تاریخ و نحوه توزیع کارت در روز دوشنبه ۹۸/۰۱/۲۶ از طریق سایت سازمان سنجش آموزش کشور منتشر خواهد شد.

همچنین سازمان سنجش در آخرین اطلاعیه خود تاکید کرده بود: " وزارت علوم، تحقیقات و فناوری و این سازمان از زمان وقوع سیل، پیگیر ارائه تسهیلات یا اختصاص سهمیه مشابه زلزله زدگان از مراجع ذیصلاح برای داوطلبانی که آسیب مستقیم دیدهاند، میباشد که به محض حصول نتیجه جزئیات آن در دفترچه انتخاب رشته به استحضار داوطلبان خواهد رسید".

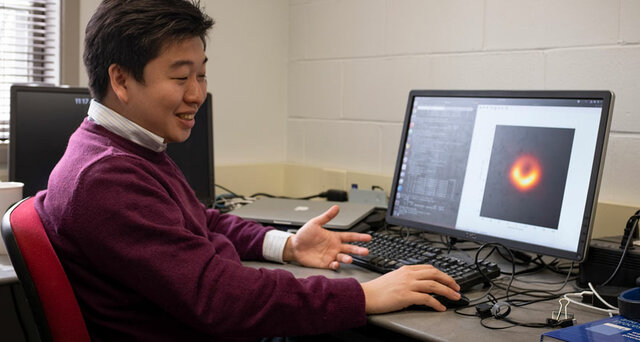

"کازونوری آکیاما" یکی از ۲۰۰ دانشمند پروژه افق رویداد و سرپرست تبدیل دادههای تلسکوپها به یک عکس است که یکی از اولین نفراتی است که موفق به دیدن اولین عکس از یک سیاهچاله در تاریخ بشر شد.

به گزارش ایسنا و به نقل از ساینس نیوز،"کازونوریآکیاما" یکی از اخترفیزیکدانان مؤسسه فناوری ماساچوست(MIT) و پروژه افق رویداد است که یکی از اولین نفراتی بوده که عکس تاریخی سیاهچاله Powehi را دیده است.

این تصویر که در روز ۱۰ آوریل برای عموم منتشر شد، مرکز تاریک یک سیاهچاله غولآسا در مرکز کهکشان M87 را نشان میدهد که توسط گازهای چرخشی محاصره شده است.

ثبت و ظهور این عکس به هیچ عنوان آسان نبوده است، بلکه حاصل تلاش شبانهروزی بیش از ۲۰۰ محقق در سراسر جهان و جمع آوری دادهها از هشت رصدخانه است.

این هشت رصدخانه در آوریل ۲۰۱۷ طی ۱۰ روز ۵ پتابایت (۵ هزار ترابایت) داده جمعآوری کردند و تجزیه و تحلیل آنها بالغ بر دو سال به طول انجامید تا سرانجام اولین عکس واقعی از یک سیاهچاله در تاریخ دهم آوریل منتشر شود.

پردازش یک تصویر از این میزان اطلاعات نیاز به مهارت بیش از ۵۰ کارشناس تصویرسازی داشت. "آکیاما" از رصدخانه "Haystack" متعلق بهMIT در وستفورد ماساچوست، تلاش برای تبدیل دادهها به تصویر نهایی را رهبری میکرد.

آکیاما و همکارانش برای این که بتوانند این تصویر را ایجاد کنند، مجبور بودند ماهها منتظر بمانند تا تجزیه و تحلیل پنج پتابایت داده خام که روی بیش از نیم تن هارددیسک ریخته شده بود، تمام شود.

متخصصان تصویرسازی دادههای نهایی را در ماه ژوئن ۲۰۱۸ دریافت کردند. آکیاما میگوید: من نتوانستم شب قبل از تحویل دادهها بخوابم چون به شدت استرس داشتم.

وی پس از دریافت دادهها بلافاصله تجزیه و تحلیل را شروع کرد و در عرض چند دقیقه به نخستین سایه از سیاهچاله رسید. او میگوید: من واقعاً خوشحال بودم، واقعاً هیجانزده شدم.

اما پس از آن آکیاما نگران شد. اگر او تنها کسی بود که تصویر سیاهچاله را به این شکل میدید چه؟ اگر دیگر دانشمندان به تصویری متفاوت میرسیدند چه؟ وی میگوید: بعد از استخراج اولین تصویر دوباره نمیتوانستم بخوابم.

این افکار خواب را از آکیاما گرفته بود و نمیتوانست مطمئن باشد تصویری که او به آن رسیده درست باشد. بنابراین برای اطمینان از اینکه تصویر نهایی دقیق است، محققان به چهار گروه تیم تقسیم شدند که هر گروه به طور مستقل کار میکرد و نتایج را باهم مقایسه میکردند.

"دنیل مارونه" اخترفیزیکدان دانشگاه آریزونا در یک کنفرانس خبری در ۱۰ آوریل در واشنگتن گفت: ما به گروهها گفتیم با یکدیگر و یا هر کس دیگری صحبتی نکنند.

این چهار گروه در نهایت پس از ۷ هفته کار بر روی دادهها و تصاویر در ماه ژوئیه ۲۰۱۸ در دانشگاه هاروارد یکدیگر را ملاقات کردند. در حالی که باز هم مجبور بودند صبر کنند تا میوه نهایی کارشان را به اشتراک بگذارند.

آکیاما میگوید: ما به شدت محتاط بودیم. در روز اول ما تصاویر را مقایسه نکردیم. در عوض همه محققان تأیید کردند که تصاویر آنها با دادهها سازگار است. در نهایت زمان انتشار عکس فرا رسید و تمام تیمها تصویر مشترک خود از این شبح سیاهچاله را نمایش دادند.

پس از این که آکیاما دید که نتایج مشترک است و تفاوتی در ماحصل کار چهار گروه دیده نمیشود، بار دیگر توانست راحت بخوابد. سرانجام مشخص شد که تصویر این سیاهچاله واقعی است، فراتر از سایه شک و تردید.

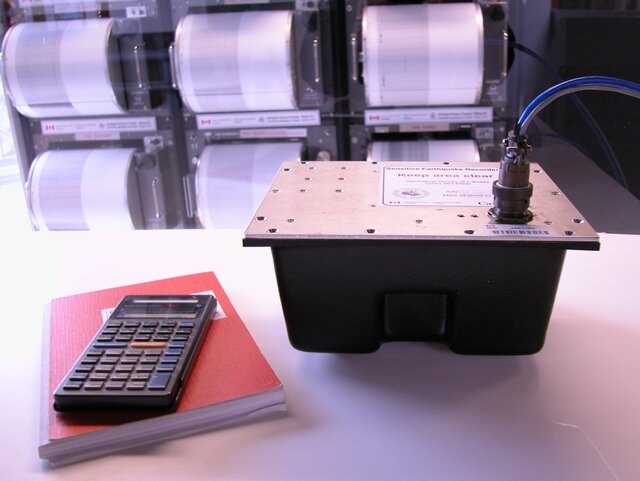

رئیس شبکه ملی شتابنگاری مرکز تحقیقات راه، مسکن و شهرسازی با تاکید بر اینکه در حال حاضر بیش از ۱۱۰۰ ایستگاه شتابنگار فعال در کشور داریم، گفت: در سال ۱۳۹۶ تعداد ۲۶۲ دستگاه شتابنگار از نوع نسل چهارم را که قابلیتهای بسیار ارزشمندی دارند، خریداری و به کشور وارد کردیم و به دلیل اهمیت استان تهران ۴۶ ایستگاه شتابنگاری از ۹۸ ایستگاه استان تهران مجهز به دستگاههای جدید شده است.

مهندس اسماعیل فرزانگان در گفتوگو با ایسنا آغاز فعالیت شبکه شتابنگاری کشور را از سال ۱۳۵۳ دانست و افزود: تا سال ۱۳۵۷ تعداد دستگاه شتابنگاری که به منظور ثبت حرکات قوی زمین ناشی از رویداد زلزله در کشور راهاندازی شد، به تعداد ۲۷۰ دستگاه شتابنگاری رسید.

وی با اشاره به اهمیت ایستگاههای شتابنگاری در کشورها، توضیح داد: در حوزه مهندسی زلزله آنچه که برای مهندسان زلزله با اهمیت است، دادههایی هستند که به آنها دادههای "جنبش نیرومند زمین" گفته میشوند که شامل شتاب حرکات زمین، سرعت حرکت زمین، جابهجایی زمین و مدت زمان دوام حرکت زمین میشود.

فرزانگان با بیان اینکه این دادهها از طریق دستگاههای شتابنگار ثبت میشوند، خاطر نشان کرد: این دستگاهها شتاب حرکت زمین در زمان وقوع زلزله را ثبت میکنند؛ چراکه نیرویی که در زمان زلزله به سازهها منتقل میشود، متناسب با شتابی است که ایجاد میشود.

رئیس شبکه ملی شتابنگاری اضافه کرد: بعد از زلزله ۱۳۹۶ رودبار که زمین لرزه بزرگی بود، شبکه شتابنگاری زلزله کشور که در آن زمان دستگاههای آن از نوع دستگاههای آنالوگ بود، با کمک وامی که از طریق مراجع بینالمللی که به دولت جمهوری اسلامی ایران واگذار شد، تعدادی دستگاه شتابنگار دیجیتال خریداری کرد و این دستگاهها علاوه بر آنکه جایگزین دستگاههای آنالوگ شدند، در نقاط لرزهخیز و در شهرها و روستاهایی که سابقه لرزه خیزی تاریخی داشتند و همچنین در نزدیکی گسلها قرار داشتند، نصب شد.

به گفته وی با این اقدام تعداد دستگاه شتابنگار دیجیتال نصب شده در ایران به مرز ۱۲۰۰ دستگاه رسید که در آن زمان یکی از بزرگترین شبکههای شتابنگار دنیا محسوب میشد.

وی ادامه داد: علاوه بر آن در سال ۱۳۸۵ در یک مقطع کوتاه حدود ۱۵۰ دستگاه شتابنگار نسل سوم به شبکه شتابنگاری کشور اضافه و عمده آنها در شهر تهران و مناطق پیرامون آن و مراکز استانها نصب شد.

فرزانگان با تاکید بر اینکه زلزلههای بزرگی توسط شتابنگاری کشور ثبت شده که برخی از آنها از اهمیت جهانی برخوردار است، یادآور شد: رکورد ثبت شده زمین لرزه طبس در سال ۱۳۵۷ از سوی دستگاه شتابنگار بعد از گذشت ۴۰ سال از رویداد آن مورد ارجاع مراجع بینالمللی، مهندسان و یا شرکتهایی که در زمینه نرم افزارهای مهندسی زلزله فعال هستند، قرار میگیرد.

وی رکورد ثبت شده از زلزله سال ۱۳۸۲ بم توسط ایستگاه فرمانداری بم را از دیگر نمونههای ثبت دادههای مهم توسط شبکه شتابنگاری ملی دانست و افزود: شتاب قائم این زلزله حدود یک G برابر شتاب ثقل زمین بوده که بزرگترین شتاب قائمی بوده که تا آن زمان در شبکه شتابنگاری کشور به ثبت رسیده بود و این "داده" موجب شد که در آئیننامه ۲۸۰۰ تغییراتی ایجاد شود.

رئیس شبکه ملی شتابنگاری اضافه کرد: علاوه بر آن در زلزله سرپل ذهاب سال ۱۳۹۶، ایستگاه شتابنگاری فرمانداری سرپل ذهاب شتابی نزدیک ۷ دهم شتاب ثقل زمین را اندازهگیری کرد که شتاب بالایی محسوب میشد و این "داده" نشاندهنده میزان خرابیهای وسیع این شهر بوده است.

وی با تاکید بر اینکه دادههای دستگاههای شتابنگاری هم از نظر بنیادی و هم از نظر مهندسی مورد استفاده قرار میگیرد، خاطرنشان کرد: علاوه بر آن بیش از ۶۰۰ دانشجو در مقاطع دکتری و کارشناسی ارشد دادههای این ایستگاهها را برای انجام پایاننامههای خود مورد استفاده قرار دادند.

فرزانگان تاکید کرد: رشتههایی مانند مهندسی زلزله و یا زلزلهشناسی مهندسی در کشور متکی بر دادههای دستگاههای شتابنگار هستند و در صورت نبود این دستگاهها، باید از دادههای سایر کشورها استفاده شود.

وی همچنین اظهار کرد: هیچ سازه مهم و استراتژیک بدون در نظر گرفتن پارامترهای زلزله نمیتواند طراحی و ساخته شود و مهمترین پارامترهایی که در طراحی مقاوم سازه در برابر زلزله مورد استفاده قرار میگیرد، دادههایی است که از سوی دستگاههای شتابنگار به ثبت میرسد.

فرزانگان آئیننامه ۲۸۰۰ را آئیننامه استاندارد زلزله در کشور دانست و گفت: بخش عمدهای از مطالب مرتبط با زلزله و نقشههای پهنهبندی آن بر اساس دادههای شتابنگاری است.

تعداد ایستگاههای شتابنگاری کشور

این فعال حوزه شتابنگاری زلزله با تاکید بر اینکه در حال حاضر بیش از ۱۱۰۰ ایستگاه شتابنگار فعال در کشور داریم، افزود: در سال ۱۳۹۶ توانستیم با تلاش فراوان تعداد ۲۶۲ دستگاه شتابنگار از نوع نسل چهارم که قابلیتهای بسیار ارزشمندی را دارند، خریداری و به کشور وارد کنیم و این دستگاهها به تدریج در نقاط مختلف کشور جایگزین دستگاههای قدیمی میشود.

به گفته رئیس شبکه ملی شتابنگاری، همه ۲۶۲ دستگاه شتابنگاری نسل چهارم خریداری شده به کشور وارد شده است و از این تعداد تاکنون ۶۵ دستگاه نصب شده است و کار نصب بقیه دستگاهها ادامه دارد. این دستگاهها از طریق مودمهای تلفن همراه اطلاعات خود را ارسال میکنند و امکان دسترسی سریعتر و برخط را برای اپراتور فراهم میکنند.

فزرانگان، اولویت نصب این دستگاهها را مراکز استانها و مناطق لرزهخیز دانست و گفت: تعدادی از دستگاههای جدید در شهر سرپل ذهاب و سایر شهرهای استان کرمانشاه نصب شده است، ضمن آنکه در تهران، تبریز، مشهد و استان هرمزگان نیز نصب شدهاند. به طور کلی سیاست ما این است که ابتدا شهرهای بزرگ و پرجمعیت و حساس به لحاظ لرزهخیزی را مجهز به این سیستمها کنیم و به تدریج دستگاههای جدید را جایگزین دستگاههای قدیمی موجود در شهرهای کوچکتر و روستاها کنیم.

وی با بیان اینکه با توجه به وسعت کشور، این تعداد دستگاه شتابنگاری برای پوشش کل کشور کافی نیست، افزود: در بررسیهای زلزله به غیر از سازههای بلند و مهم، نیاز است پلها، تونلها و سدها و نیروگاهها به دستگاههای شتابنگاری و ثبت کننده زمینلرزه مجهز شوند.

این محقق تصریح کرد: تعدادی از سدهای کشور مجهز به دستگاههای شتابنگاری است که یا توسط آنها خریداری شده است و یا ما برای آنها نصب کردیم و به آنها خدماتی ارائه میدهیم، ولی در مورد نیروگاهها این امر رخ نداده و در زمینه تجهیز سازههای مهم و بلند به دستگاههای ثبت زلزله متأسفانه در این زمینه پیشرفت چندانی نداریم.

زلزلههای استان تهران

رئیس شبکه ملی شتابنگاری به تعداد زلزلههای رخ داده در استان تهران اشاره کرد و گفت: شهر تهران در پهنهای قرار گرفته است که از لحاظ تاریخی لرزه خیز بوده است و بررسیهای تاریخی گستره شهر تهران و پیرامون آن مانند "ری" نشان میدهد که در طول تاریخ زمین لرزههای تاریخی بسیاری داشته است.

وی تمرکز مراکز جمعیتی و سیاسی و وجود گسلهای فعال را از عواملی دانست که اهمیت شهر تهران را دو چندان میکند و ادامه داد: علاوه بر آن آسیب پذیری این شهر را نیز افزایش داده است، از این رو در شبکه شتابنگاری به استان و شهر تهران توجه بیشتری داشتیم، به گونهای که در مجموع ۹۸ ایستگاه در کل استان تهران داریم که از این تعداد ۴۶ ایستگاه مجهز به دستگاه جدید شتابنگاری است و از ۹۸ ایستگاه در استان تهران ۵۹ ایستگاه در شهر تهران مستقر شده است.

فرزانگان با بیان اینکه در استان تهران تمرکز ما بر شهر تهران بوده است، افزود: از ۵۹ ایستگاه شتابنگاری شهر تهران ۳۶ ایستگاه آن از دستگاههای شتابنگار استفاده شده است و ما درصدد هستیم که تعداد دستگاههای جدید شتابنگار شهر تهران را اضافه کنیم.

وی با بیان اینکه شبکه ایستگاه شتابنگاری در تهران از تراکم خوبی برخوردار است، اظهار کرد: از تعداد زمینلرزههایی که از سال ۱۳۵۳ در استان تهران و مناطق پیرامون آن رخ داده است، ۴۴۷ رکورد ثبت کردیم. یعنی ۴۴۷ شتاب نگاشت به ثبت رسیده است.

فرزانگان اضافه کرد: از این تعداد ۲۱۲ رکورد مربوط به ایستگاههایی بوده که در شهر تهران مستقر شده است و ۲۳۵ رکورد از سوی ایستگاههای استان تهران به ثبت رسیده است.

به گفته وی، بیشترین شتاب ثبتشده در استان تهران در ایستگاه فیروزکوه بوده که شتاب آن در حدود ۴۰۲ سانتیمتر بر مجذور ثانیه است و بزرگی زمین لرزهای که مسبب این شتاب بوده، حدود ۴.۲ بود؛ ولی در شهر تهران بیشترین شتابی که ثبت کردیم، ۵۶ سانتیمتر بر مجذور ثانیه بوده که زلزله مسبب آن با بزرگی ۴.۴ گزارش شد.

وی خاطر نشان کرد: در شهر تهران و پیرامون آن عمدتاً زمین لرزههای متوسط داشتیم و زمین لرزه با بزرگای بیش از ۶ در چند دهه اخیر نداشتیم، ولی زمین لرزه با بزرگای ۵ و کمتر تعدادی در استان تهران روی داده است.

رئیس شبکه ملی شتابنگاری اظهار کرد: بیشترین ایستگاههای فعال شتابنگاری شهر تهران در شرق استان تهران و در مناطقی چون مشا، فیروزکوه، لواسان، فشم و دماوند مستقر است و از نظر شتابنگاری بخشهای شرق تهران فعالتر از بخش غربی تهران در چند سال اخیر بوده، ولی زمین لرزه سال ۹۶ منطقه ملارد نشان داد که غرب استان تهران نیز از پتانسیل زمینلرزه برخوردار است.

نصب دستگاه جدید شتابنگاری در دماوند

وی در خصوص تجهیز منطقه دماوند با دستگاههای نسل جدید شتابنگاری، گفت: در حال حاضر در شهر دماوند و فیروزکوه در هر کدام یک دستگاه نسل چهارم شتابنگاری نصب شده و در برنامه داریم که در امتداد مسیری که به استان مازندران میرسد، در شمال کوه دماوند این دستگاهها نصب شود تا بتوانیم پوشش مناسبی داشته باشیم.

رئیس شبکه ملی شتابنگاری ابراز امیدواری کرد که با خریداری دستگاههای بیشتر شتابنگاری، این پوشش متراکمتر شود.

وقتی زبالهها بهصورت غیر اتوماتیک و توسط نیروی انسانی تفکیک میشوند، هم از نظر بهداشتی و هم از نظر ایمنی میتوانند مخاطراتی برای کارگرانی که در چنین پروسههایی فعالیت میکنند، ایجاد کرده و تفکیک زباله را به کاری طاقتفرسا تبدیل کنند. اما آیا رباتها میتوانند جای نیروی انسانی را در تفکیک زباله بگیرند؟ آیا رباتها میتوانند تفاوت بین مقوا و قوطی فلزی را تشخیص بدهند؟

محققان MIT CSAIL، موفق به توسعهی رباتی شدند که میتواند با کمک حس لامسه، زبالهها را تفکیک کند. رباتروسایکل (RoCycle) میتواند با استفاده از حسگرهایی که روی بازوهای مکانیکی آن تعبیه شده است، جنس مواد را تشخیص دهد و آنها را براساس جنس، تفکیک کند. ربات مجهز به سنسوری با خاصیت ارتجاعی است که میتواند اندازهی اجسام را اندازهگیری کند.

مقالههای مرتبط:

همچنین روسایکل مجهز به دو حسگر فشار است که با وارد کردن فشار به بدنهی هر جسم میتواند تشخیص دهد آیا آن شی بهراحتی قابلیت خرد شدن را دارد و شکسته میشود یا از چنس پلاستیک سخت است. باتوجه به اینکه سنسورهای تعبیهشده روی بازوی مکانیکی رسانا هستند، قابلیت تشخیص فلزات را نیز دارند.

دستهای ربات مکانیکی از جنس اکستیک است. اکستیکها موادی هستند که در حین کشش، ضخامت بیشتری پیدا میکنند. هریک از انگشتان دست ربات از اکستیکهای دست چپ و دست راست تشکیل شده است که در حین چرخش، اجازهی حرکت دینامیکی بیشتری را نسبت به رباتهای معمولی میدهد و دیگر نیازی به استفاده از پمپهای هوا و کمپرسورهای روباتهای نرم هم نیست.

ربات روسایکل در یکی از کارخانههای محلی بازیافت مورد استفاده قرار گرفت. روسایکل در تشخیص اجسام ثابت، دقت ۸۵ درصدی از خود نشان داد و هنگامی که اجسام روی نقالهی شبیهسازیشده در مقابل ربات قرار میگرفتند، دقت ۶۳ درصدی را در تشخیص و تفکیک اجسام با جنسهای مختلف نشان داد.

بازیافت زباله در زندگی واقعی هم پیچیدگیها و مسایل خاص خودش را دارد. مثلا خیلی اوقات این اشتباه پیش میآید که فردی شیشهی نوشابه را در سطل مخصوص زبالههای کاغذی قرار دهد. در چنین مواردی باید دید آیا روسایکل میتواند دقت خوبی از خود نشان دهد یا خیر. درحالیکه محققان MIT هنوز در حال توسعهی این ربات هستند، بهنظر میرسد در گام بعدی سیستم حسگر لامسهی روسایکل با دوربین ترکیب شود تا بتواند از بینایی کامپیوتری نیز درکنار حسگر لمسی برای تفکیک زبالهها کمک بگیرد.

توسعهی چنین رباتهایی میتواند تاثیر قابلتوجهی بر فرایند تفکیک زبالهها داشته باشد. چنین رباتهایی، نمونهی آشکاری از نقش و تاثیر رباتها بر زندگی و مشاغل را نشان میدهند. انتظار میرود با توسعهی چنین رباتهایی، کارگران تفکیک زباله بتواند شغلهایی با ایمنی بالاتر و البته دلپذیرتر داشته باشند. همچنین چنین فناوریهایی میتواند هزینههای تفکیک زباله را بهمراتب کاهش دهد و بهشکل چشمگیری از ذفن زبالههایی که میتوانند بازیافت شوند، کمک میکند.

.: Weblog Themes By Pichak :.